Valutazione dell’Incertezza e Calibrazione del Modello

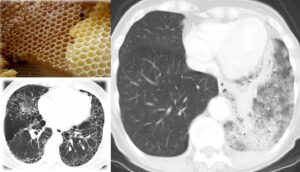

La valutazione dell’incertezza e la calibrazione del modello sono passaggi fondamentali per migliorare l’affidabilità e l’interpretabilità dei modelli di ML, in particolare in ambiti critici come l’imaging medico e la radiomica.

- Valutazione dell’incertezza: Consiste nel quantificare gli intervalli di confidenza delle predizioni del modello, utilizzando tecniche come l’inferenza bayesiana, il bootstrapping o i metodi ensemble. Il bootstrapping è particolarmente popolare e implica eseguire più test tramite campionamento con ripetizione dal dataset di test.

- Calibrazione del modello: Mira ad allineare le probabilità predette con i risultati effettivi. Un modello ben calibrato produce stime di probabilità che riflettono le reali probabilità, essenziale per valutazioni del rischio e processi decisionali. Tecniche come il Platt scaling o la regressione isotona vengono utilizzate per correggere le probabilità predette e migliorare l’allineamento con le frequenze osservate.

Confronto tra Modelli

Nelle ricerche radiomiche, spesso vengono sviluppati diversi modelli per dimostrare il valore aggiunto dell’approccio radiomico, incorporando vari tipi di predittori (solo clinici, solo radiomici o una combinazione di entrambi).

- Confronto dei modelli predittivi: Serve a identificare i modelli più efficaci e a valutare la superiorità degli approcci radiomici rispetto a quelli tradizionali.

- Valutazioni uni-parametriche e multi-parametriche: In studi che coinvolgono sequenze MRI diverse (es. T2-weighted e diffusion-weighted), è necessario effettuare anche analisi uni-parametriche per giustificare l’adozione di un modello multi-parametrico.

- Confronto con approcci non radiomici: È importante confrontare i metodi radiomici con approcci comunemente usati nella pratica clinica, come le caratteristiche semantiche, i punteggi RADS o RECIST, e le valutazioni basate su dimensioni o volumi. Se non sono disponibili metodi non radiomici, si dovrebbe dimostrare un miglioramento nella precisione diagnostica o negli esiti clinici (es. miglioramento delle prestazioni dei radiologi o della sopravvivenza complessiva).

- Confronto con modelli di riferimento semplici: Confrontare i modelli con baseline semplici, come un classificatore Zero Rules (No Information Rate), per giustificare l’uso di metodi ML più complessi dimostrando un aumento delle prestazioni.

Metodi statistici per il confronto tra modelli:

- DeLong Test: Utilizzato per confrontare le aree sotto le curve ROC (Receiver Operating Characteristic) di due o più modelli di classificazione.

- McNemar’s Test: Analizza dati nominali appaiati per determinare differenze tra due gruppi correlati, spesso applicato direttamente alle matrici di confusione per valutare i tassi di errore di classificazione.

- Analisi delle curve decisionali: Per confrontare il beneficio netto tra modelli

- Net Reclassification Index (NRI): Misura l’efficienza del miglioramento della classificazione tra modelli.

- Correzione per confronti multipli: Per ridurre il rischio di errori di tipo I (falsi positivi) in analisi multiple, si utilizzano metodi come Bonferroni, Benjamini-Hochberg o Tukey.