La Necessità di Selezione delle Features e Regolarizzazione

Non tutte le features estratte sono utili per essere utilizzati nei modelli di radiomica, rendendo quindi necessarie tecniche di selezione delle features. Un problema cruciale negli studi radiomici è l’elevata dimensione dei dataset, che comporta: (1) una grande richiesta computazionale e (2) un numero eccessivo di features, che possono ridurre le prestazioni del modello a causa dell’overfitting. Pertanto, i metodi di selezione delle features vengono utilizzati per semplificare il modello eliminando quelle ridondanti e irrilevanti. Il sottoinsieme di features selezionate dovrebbe essere ridotto al minimo ma sufficiente nell’identificare accuratamente il target e, idealmente, dovrebbe migliorare l’accuratezza del modello di previsione. Tuttavia, nel processo selezione, esiste il rischio di perdere informazioni importanti; per questo motivo, la scelta del metodo è una fase cruciale nella pipeline di uno studio radiomico. Mentre nella radiomica tradizionale la selezione delle features è una fase esplicita e fondamentale, nella deep radiomics è spesso integrata nel processo di apprendimento del modello stesso.

Metodi di selezione

I metodi di selezione delle features possono essere distinti in base alla relazione con il modello di apprendimento, in filtri, wrapper ed embedded.

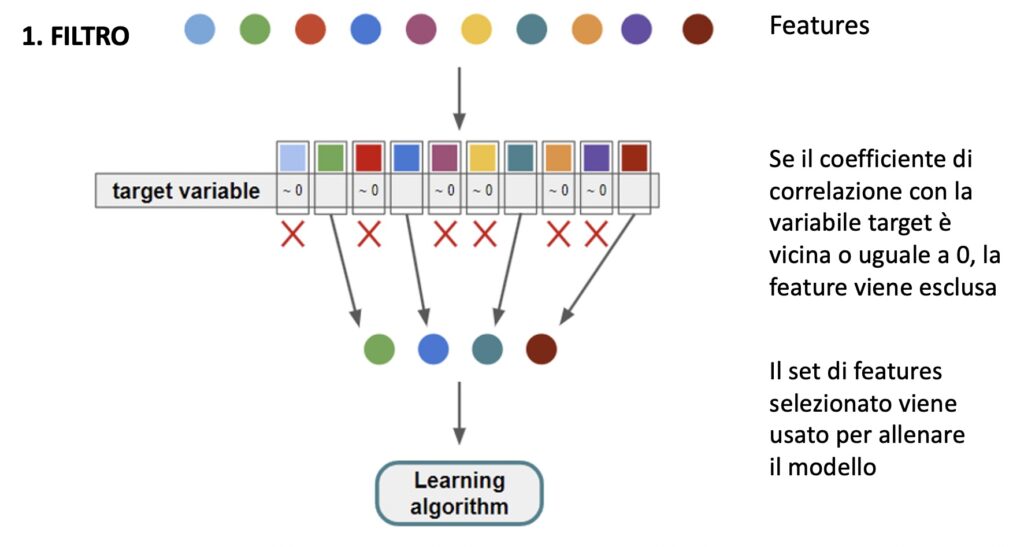

1. Filtri

- Con i filtri, le features vengono valutate tramite misure statistiche semplici (come correlazione o test χ²), applicando delle soglie per decidere quali features includere.

- Vantaggi: Rapido ed efficiente, non introduce bias verso uno specifico modello.

- Svantaggi: Non tiene conto di come le features lavorano insieme all’interno del modello finale.

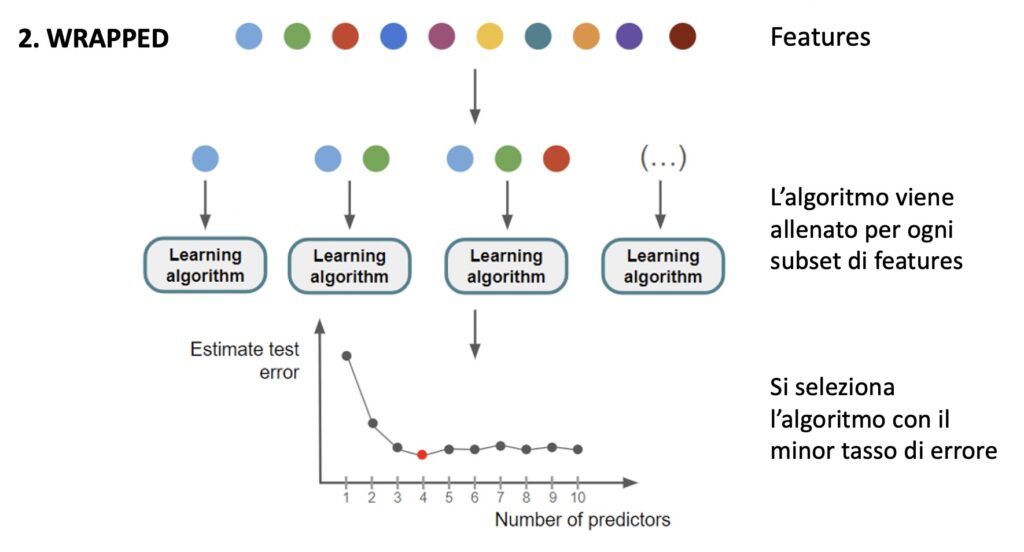

Wrapper:

- La selezione delle features è guidata dal modello di apprendimento. Si generano diversi sottoinsiemi di features, e si addestra il modello su ognuno di essi per vedere quale subset dà le prestazioni migliori. Metodi comuni includono la selezione best subset e quella stepwise (aggiunta o rimozione di features in modo incrementale).

- Vantaggi: Fornisce soluzioni più ottimizzate e personalizzate per il modello.

- Svantaggi: È più lento e costoso computazionalmente, specialmente con grandi dataset e molte features.

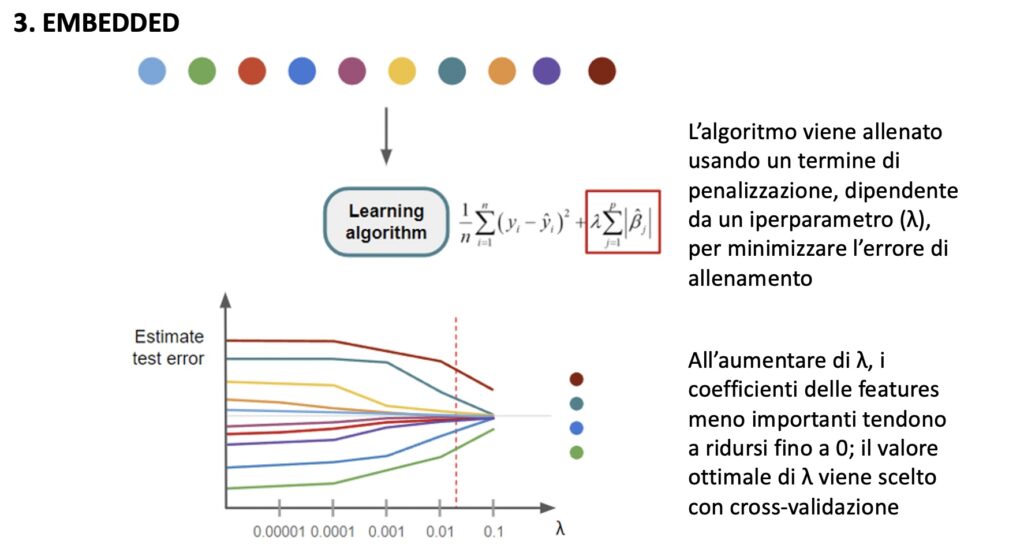

Embedded:

- La selezione delle features è integrata direttamente nel processo di costruzione del modello. La selezione avviene durante l’addestramento, con tecniche come la regolarizzazione (ad esempio, il metodo LASSO) che riducono a zero i coefficienti di features meno importanti.

- Vantaggi: Combina i vantaggi dei metodi filter e wrapper, bilanciando efficienza e ottimizzazione.

- Svantaggi: Può essere più complesso da implementare e richiede modelli con capacità di regolarizzazione.