Compromesso Bias-Variance

Il compromesso tra bias e variance è fondamentale nel Machine Learning (ML), poiché molte delle sfide e delle questioni metodologiche mirano, in ultima analisi, a ottimizzare questo equilibrio.

- Bias. Il bias misura la differenza media tra i valori previsti e i valori reali, riflettendo la precisione con cui un modello può fare previsioni sul dataset di addestramento. Un bias elevato indica che il modello non sta catturando i pattern sottostanti dei dati. D’altra parte, la

- Variance. La variance misura la variabilità delle previsioni del modello su diversi dataset, indicando quanto bene il modello riesce a generalizzare su nuovi imput di dati. Una variance elevata significa che il modello è troppo sensibile ai dati di addestramento, ma commette molti errori quando incontra imput mai visti prima (errore alto nel dataset di test).

In sostanza, bias e variance rappresentano la precisione del modello per quanto riguarda rispettivamente i set di addestramento e di test. All’aumentare della complessità del modello, il bias diminuisce mentre la variance aumenta. Sebbene gli sviluppatori mirino a ridurre entrambi, spesso non è possibile farlo contemporaneamente, rendendo necessaria la regolarizzazione, che diminuisce la variance del modello a costo di un aumento del bias.

Il concetto di bias e variance è strettamente correlato all’overfitting e all’underfitting.

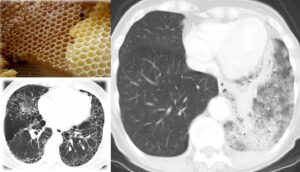

- Overfitting. L’overfitting si verifica quando il modello ha un bias basso ma una variance elevata, catturando il rumore e le fluttuazioni nei dati di addestramento piuttosto che i pattern sottostanti. Introducendo regolarizzazione e selezione delle caratteristiche, la variance del modello diminuisce e le sue prestazioni sui dati di test migliorano, a costo di un leggero aumento del bias.

- Underfitting. L’underfitting si verifica quando un modello ha sia bias che variance elevati, con conseguenti scarse prestazioni sia sui dati di addestramento che su quelli di test. Ciò accade spesso quando il modello è troppo semplice o i dati di addestramento sono insufficienti.

La costruzione di modelli con buone prestazioni richiede un gran numero di predittori. Tuttavia, questa complessità può portare a overfitting, creando un ciclo svantaggioso in cui il modello si adatta troppo strettamente ai dati di addestramento e ha scarse prestazioni sui dati non visti.